新卒1年目がゲームのギルドマスターとしてマネジメントと真面目に向き合った話

新卒1年目、わたしはとあるゲーム会社に就職した。

就職したゲーム会社の熱狂的なファンだったが、他社のゲームをほとんどプレイしたことがなかったため、勉強をするために様々なゲームをプレイしていた。

その中で、1つのゲームにドハマリした。自分の村を育てながら個人やギルド*1で対戦をするクラッシュオブクランというスマホのストラテジーゲームだった。

ゲーム自体はもちろん面白いのだが、ドハマリした理由はそれよりもチームメンバーとの毎日の雑談が楽しかったのが大きい。オンラインになれば「くーちゃん、お仕事終わったの?おつかれさま!」と毎日言ってもらえる、そんなチームに居場所を感じた。ちなみにそのチームに参加した理由はチーム名に「もふもふ」が入っていて可愛かったからだ。もふもふ。

ゲームにはチーム対戦(5vs5~50vs50)の仕組みがあり、所属していたチームは週に何度か対戦を開催するほどほどにゆるくゲームを楽しめるチームだった。

そんなゲームで、新卒1年目の私がマネジメントに真面目に向き合い・挫折し・学んだことを書いてみようと思う。

リーダーがお怒りです!

ある日、おちゃめなリーダーが苛立っていた。

対戦の準備がうまく進んでいないからだ。対戦を実施する前にはメンバー同士で村に援軍を贈り合う必要があるのだが、リーダーは他のメンバーに援軍を送っているにも関わらず、リーダーの村には誰も援軍を送っていなかった。(自分の村にはセルフ援軍できない仕様)

当時、その状況を把握しながらも自分はレベルが弱すぎて協力できず*2、もどかしい気持ちで見ていた。「直前になっても他の方が送られないようであれば、弱い援軍ですけど私が送りますね」といって対戦の直前まで待機したりしたものだった。

新卒、40人チームのリーダーになる

上記のようなことが何度か続くようになり、あきらかにリーダーは疲弊しているのを感じていたのだが・・・。

ある日ログインすると、自分の肩書がリーダーに変わっていた。元リーダーは「あとは頼んだ!君ならできるよ!」というようなことを言い残し、チームを出ていってしまった。

大混乱した。頑張ってくれているリーダーを支えたいとは思っていたが、まさか自分がリーダーに任命されてしまうとは思いもしなかった。

楽しそうな海賊船に乗り込んで端っこでリーダーやメンバーを眺めながら茶々を入れていただけなのに、ある日突然操縦席を明け渡されてしまったような気分だ。目指すゴールが全くわからない。それでもこのチームを守るために自分が舵を取るしかない。

向かうべきゴールのヒントを探すため、チームの紹介文を見直してみると「もふもふみんなで対戦と雑談を楽しむチームです」と書いてある。

ふむ。とりあえずこれを目指して頑張ってみよう。

これまで学校や部活でもリーダー職にも就いたことがない私は、「リーダー 仕事」でググるところから始まった。

新米リーダー、組織の理想を考える

まずはじめに、今までの組織で悪かったところを変えようと思った。

元リーダーがリーダーを続けられなくなったのはなぜなのか。

良い意味でも内輪感の強いチームだったので、ルールやメンバーの役割をあまり周知しておらず、「これは常識だよね?」でいろんな物事が進んでおり、

- 新しく入ってきた人がチームのルールを把握できていない

- 他の幹部メンバーが自分の役割を把握していない

というのを感じていた。

それにより、リーダーと空気が読める人にチーム運営の仕事が偏ってしまってしまい、彼らの負担が増えてしまっていたのが原因だと考えた。そこで、

- チームのルールやメンバーに期待していることを明文化し、新しいメンバーも把握できるように繰返しアナウンスする

- 幹部メンバーに運営のお仕事をできるだけ手伝ってもらう

というのを、改革第一弾として実施した。

チーム運営のおしごと

ゲームのチームの運営タスクとは一体どんなものがあるのか。やっていたゲームにおいては、

- 週に2回対戦を組む

- 援軍を入れる (対戦の準備をする)

という大きなタスクがあった。これはそんなに難しくない。自分で対戦を組んで、みんなにお願いして援軍を入れてもらう。

でもすぐに気づいたのだけど、それだけやっていてもチームは持続しない。

ゲームに飽きた人がログインしなくなり、運営が気に入らないひとは別のチームに移動し、すぐに廃墟と化してしまう。

持続可能な良いチームを運営するためには

- 新規メンバーの勧誘 (採用活動)

- 新規メンバーへの歓迎対応・チームのルールの周知

- チームの雰囲気作り

といったことが重要になり、むしろこちらのほうが大変なタスクだった。

良いチームを持続させるのは簡単じゃない

リーダーに就任して数ヶ月。 勧誘した新しいメンバーがなかなかチームに居着かず、元リーダーが好きだった既存メンバーも何人か辞めてしまい、じわじわと人が減っていった。

状況が変わってしまえばメンバーの入れ替わりは起こるもので、これは会社や他の組織にいても同じことだ。

ゲーム内には無数のチームがある。たくさんの人がチームを作るが、ほとんどのチームでは会話もあまりなく、人が激しく入れ替わり、対戦だけが毎週開催されるような状態がこのゲームでは普通だ。私が最初このチームに感じていた「チームメンバーとの毎日の雑談が楽しい」と思える状況は元リーダーやメンバーの努力があって実現していたことだったのだとわかった。

チームのコンセプトを明確に

新しいメンバーがなかなかチームに居着かない原因として、チームのコンセプトが明確になっておらず、

「もふもふみんなで対戦と雑談を楽しむチームです」この文章からは、

- 対戦は勝ちたいのか?楽しめればよいのか?

- 対戦に毎回負けても楽しいものなのか?指揮が下がらないか?

- 対戦をずっとしたくない人はチーム的にはOKなのか?(増えすぎると盛り上がる対戦が開催できない)

といったことがわからなかった。みんなはどうおもってチームに参加したのだろうか。

私にどうしてほしいのだろうか。

どうしたらいいのか迷っていたところ、チームを支えてくれていた古参メンバーに

「あなたのチームなんだから、あなたのやりたいようにやれば良いんだよ」

というようにアドバイスをもらった。

なるほど、それでいいのか。

例え今のコンセプトと多少変わっても自分のやりたい方向性にしたらよい。

以前のチームを守ろうとしても、自分の思いとそれが違えば守るのは難しい。

私は自分のやりたいように、「ゲームを楽しみつつ、チーム内での会話を楽しみながら勝ちを目指していく」という方向性に舵をとることにした。

古参、去る

新しいコンセプトでのチーム作りを頑張っている中、一番コアともいえる古参メンバーがチームを去ることになった。

かつて所属していたベンチャー企業でもよくみていた光景だった。ベンチャー企業では組織はどんどん変化していく。変化に適応できないと感じたメンバーや、活躍できる組織のフェーズが異なるメンバーが退職していくことは、悪いことではない。自然なことだ。

私が作った環境は、古参メンバーには合わない環境だったのだろう。しかしそのメンバーたちとゲームを楽しみたいという気持ちでリーダーを頑張っていたので、簡単にはその変化を受け入れられなかった。

何晩も泣いたのを覚えている。

リーダーとエースの兼任、独裁者の誕生

古参の強いメンバーがやめてしまったことで、私がギルドで一番強いメンバーになった。

しばらくして、大きな問題点に気づいた。

私の運営に意見してくれるメンバーがほとんどいなくなってしまったのだ。

部活でも部長とキャプテンは別だ。仕事をしていても、技術的に一番優れている人がマネージャーを兼任するのは、良くないと思っている。

一番できるひとがマネージャーやリーダーを担うと、その人の発言が絶対的な効力を持ちがちで、 気づけば自分は独裁者になっていた。

「これからはこうしようと思うけどどうかな?」

聞いてみるけど、だれも反対はしない。

だけど、結果的にそれが合わなかった人は、黙ってチームを出ていってしまう。

ゲームのチームに所属するのは簡単だし、脱退するのも簡単だ。仕事だったら社員と会社は契約やお金で繋がれているし、不満があればそれを伝えてくれるメンバーもいる。でもゲームのチームに不満があったときに、それを伝えてくれるメンバーはほんの一部だ。ほとんどはなにも言わずにチームを去ってしまうだけである。

独裁者になりたいわけではない。自分は誰かに無理を強いていないか、どうしたらみんなの気持ちを汲み取ることができるのかを考えるけれど、できることは多くなかった。

いつもチームを良くしたい気持ちと、不安な気持ちで押しつぶされそうだった。

(ところでこの気持ちを経験してから、ゲーム以外でも発言権の強い人がいる組織では、その人のためにもなると思って自分の考えを言うのを控えないように気をつけている。)

組織は2割の協力的なメンバーに支えられている

その後いくらか平和にギルドが運営できる日々が続いた。人の入れ替わりはあったが、 チームの運営がうまくいっていて雰囲気が良いときと、あやういときがあった。

何が違うんだろうと考えたときに、リーダーの他に積極的にチームのタスクや雰囲気をづくりをしてくれる人の人数だと思った。

30~40人のメンバーがいるとき、6~8人くらいそういったメンバーがいると心強い。

3~4人しかいないと、チームとしての雰囲気作りが難しいと感じた。

調べてみると「パレートの法則」とか「働きアリの法則」というのなのかなと思う。

組織のうちによく働いてくれる人を2割以上を保つことがチームを保つ秘訣だと感じ、最低限2割メンバーに積極的にチーム活動に貢献してもらえるよう、育成・勧誘に努めるようになった。

チームの目的と、私の目的

チームの運営を頑張っているからこそ、高みを目指したい。

だんだんとゲームにのめり込むことにより、対戦の勝利への欲が湧いてきてしまった。

しかし、自分のチームでそれをチームメイトに強制するのはコンセプトからかけ離れてしまう。

そこでサブアカウントを作り、そちらでは大会に出場するような強いチームにメンバーとして参加した。

幹部としての肩書のないゲームはめちゃくちゃ楽しかった。そちらのチームでもチームとしての組織課題はたくさんあるものの、自分の「強くなりたい」という気持ちを否定せずに楽しめることが嬉しくて、楽しかった。

そうこうしているうちに、自分の「強くなりたい」気持ちが大きくなり、自分のチームの「ゆるふわな空気のチームを作ること」へのプレッシャーを重く感じるようになってしまった。

このチームの強みは

- ゆるふわに対戦と雑談を楽しめること

- ゲームを開けば朝や夜の挨拶ができる、あたたかいメンバーがいること

だし、これからもそうであってほしい。でも、このチームを「勝てるチーム」にしたいわけではない。この葛藤が大きくなり、次第に仕事に集中できなくなってしまった。

さよなら、ギルド

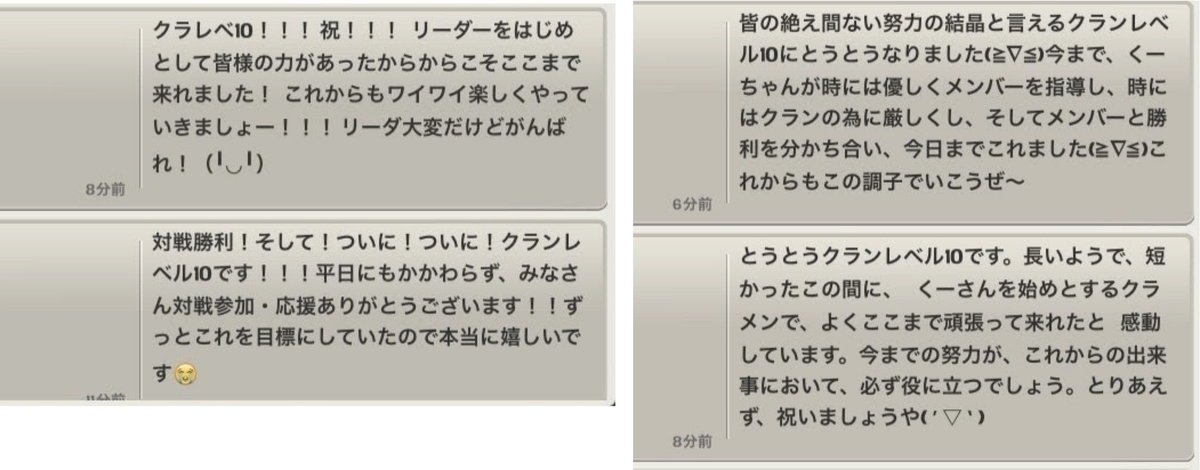

そして、「チームのクランレベル*3を最大値まで上げる」という大きな目標を達成した後しばらくして、リーダーをやめることにした。

自由になった私は、大会に出場するような他のチームに入ろうと思った。だけど、リーダーをやめた瞬間あれだけあった熱がさっと冷めてしまった。結局私はあのチームで対戦をするのが、勝つのが楽しかった。強くなりたかったはずだったのに。

社会人になって3年目のある日、ゲームは辞めてしまった。

ゲームを通して、中学生~お父さんと同じくらいの年齢の人の友達がたくさんできたし、チームを運営することで、リーダーやマネジメントの難しさを学ぶことができた。

本当に楽しくて、良い経験だった。

この記事を書きながら、懐かしくなり3,4年ぶりにチームの様子を見に行ってみたら、今でもめちゃくちゃ活発だったし、最後にリーダーをまかせた人をはじめ見覚えがあるメンバーが何人かいるようだった。

今もあのギルドが誰かの居場所になってくれているのだろう。

想像したら嬉しくてこれを書きながら泣けてきてしまった。

私がいつか現実で組織をマネジメントしなければ行けなくなったとき、あのときよりもいくらか良い組織運営ができるだろうか。今はせめて組織を支えられる人を目指そうと思いながら目の前の仕事に取り組んでいる。